10:47 AM — Los resultados de creatinina de José García llegan al servidor FHIR del hospital. 2.1 mg/dL — un aumento del 35% frente al mes pasado.

¿Qué pasa después?

- En un sistema típico: ❌ El resultado queda en una cola hasta que un clínico lo revise manualmente, horas o días después.

- Este sistema de ejemplo: 👍 Un agente de IA evalúa la tendencia, consulta guías clínicas y genera recomendaciones basadas en evidencia, en segundos y de forma automática.

Sin chatbot. Sin prompts manuales. Sin razonamiento de caja negra.

Esto es soporte a la decisión clínica impulsado por eventos con trazabilidad completa:

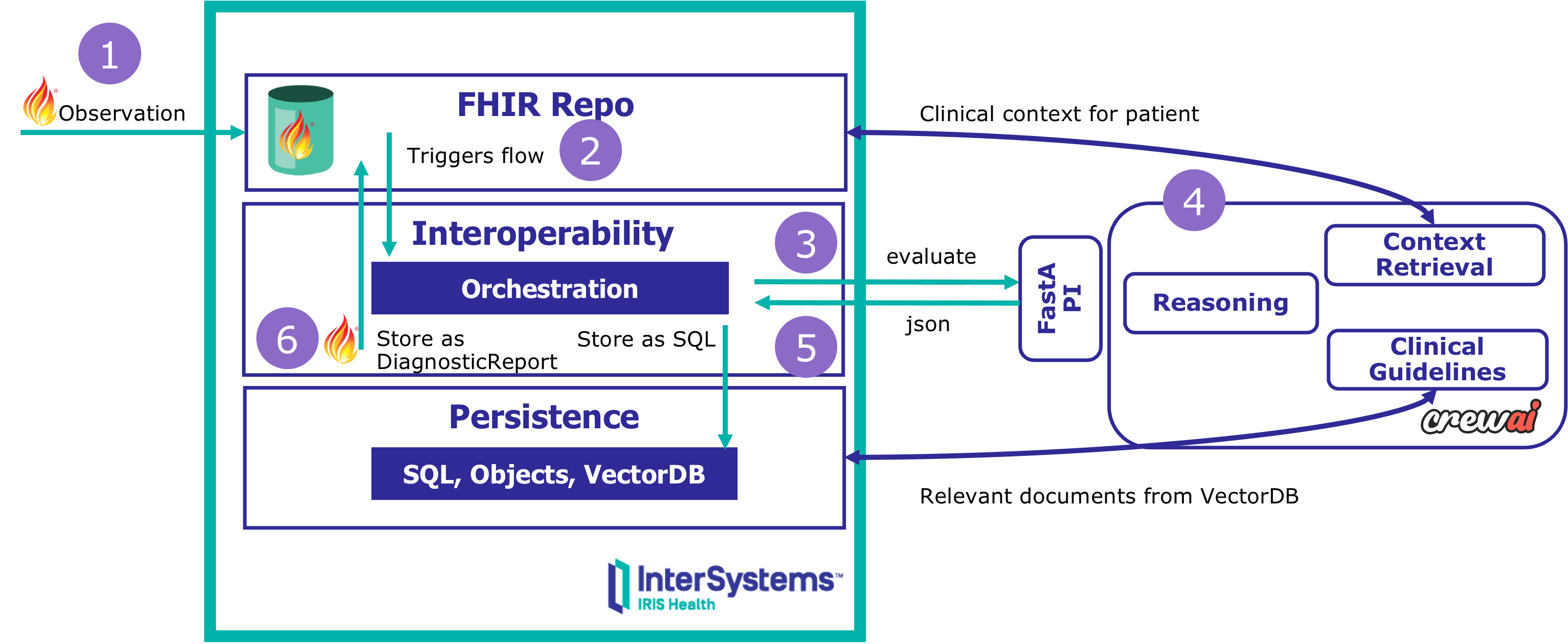

✅ Activado automáticamente por eventos FHIR ✅ Razonamiento multiagente (contexto, guías, recomendaciones) ✅ Trazabilidad completa en SQL (cada decisión, cada fuente de evidencia) ✅ Salidas nativas FHIR (DiagnosticReport publicado en el servidor)

Construido con:

- InterSystems IRIS for Health — Orquestación, FHIR, persistencia, búsqueda vectorial

- CrewAI — Framework multiagente para razonamiento estructurado

Aprenderás: 🖋️ Cómo orquestar flujos de IA agéntica dentro de sistemas de interoperabilidad listos para producción, y por qué la explicabilidad importa más que la precisión por sí sola.

<iframe width="560" height="315" src="https://www.youtube.com/embed/43Vl7cU_uNY?si=o3NZ3AqPOdFkCn9w" title="YouTube video player" frameborder="0" allow="accelerometer; autoplay; clipboard-write; encrypted-media; gyroscope; picture-in-picture; web-share" referrerpolicy="strict-origin-when-cross-origin" allowfullscreen></iframe>